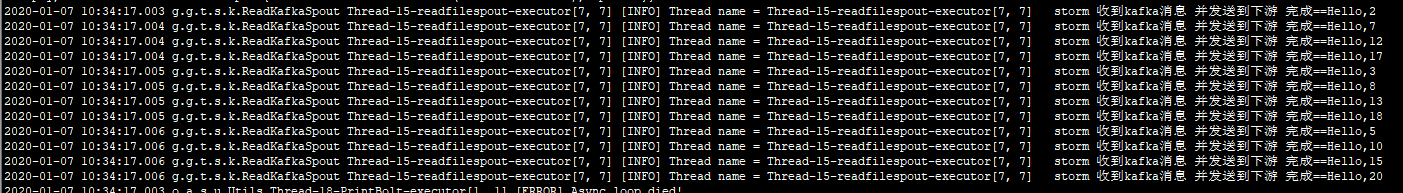

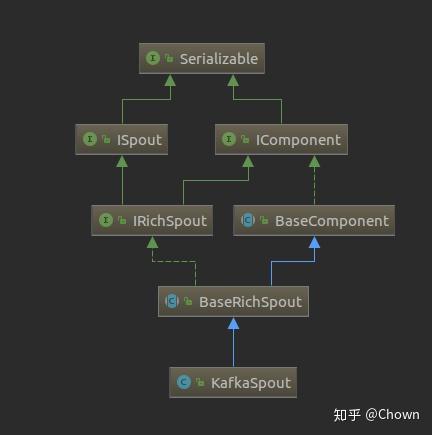

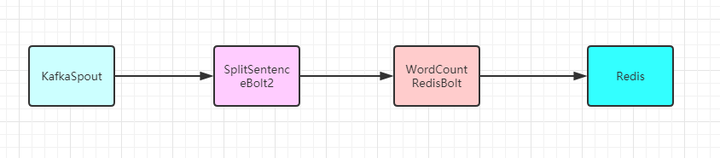

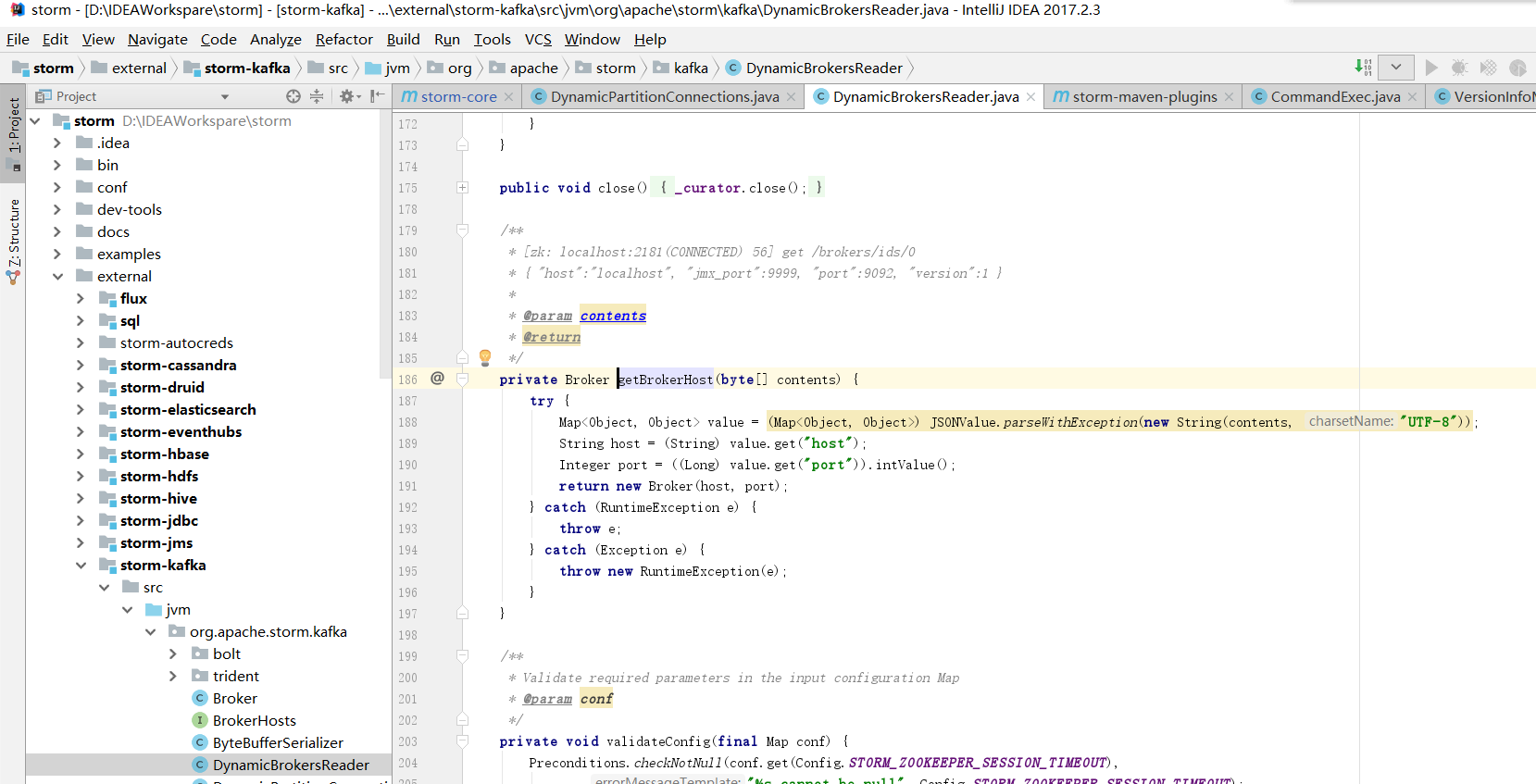

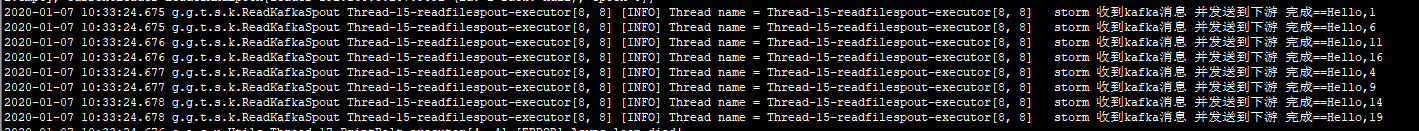

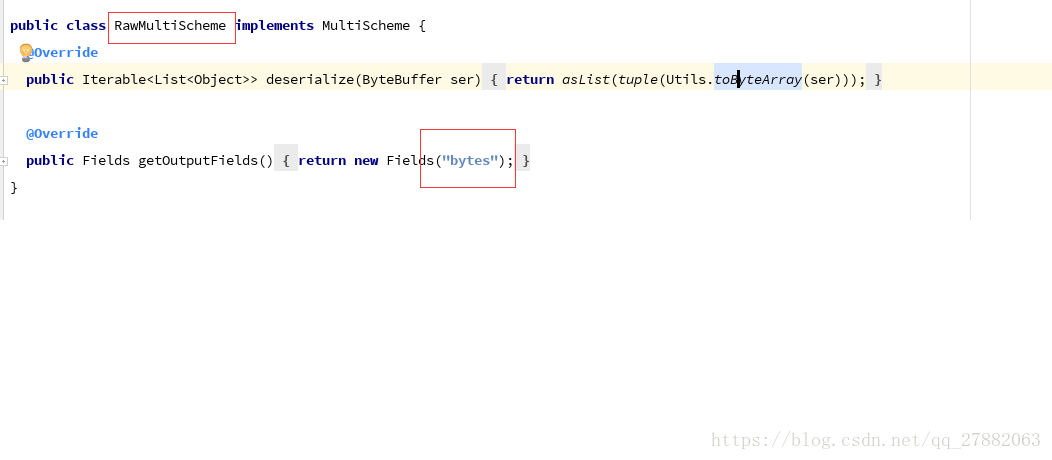

Jun 05, 17 · storm消费kafka的速度在ui里面是看不到的。 所以是需要 一款kafka的监控软件,来监控storm消费kafka的情况。 经过比较,选择了KafkaOffsetManager这款工具。 这款软件的优点是,直接是一个jar,可以直接运行,对kafka集群没有要影响。 但是使用中有几个问题要注意。Oct 09, 17 · 这里讲述如何在storm中消费kafka队列中的消息。 为何在项目中两个拓扑文件校验和预处理之间要用kafka消息队列进行数据的暂存仍需要去落实。 项目中直接使用storm提供的kafkaSpout作为消息队列的消费者。 实现spout从kafka消息队列获取数据,作为拓扑的数据源。 package comlancytopology;May 04, 19 · 创建消费kafka的spout,直接用storm提供的KafkaSpout即可。 创建处理从kafka读取数据的Bolt,JsonBolt负责解析kafka读取到的json并发送到下个Bolt进一步处理(下一步处理的Bolt不再写,只要继承BaseRichBolt就可以对tuple处理)。

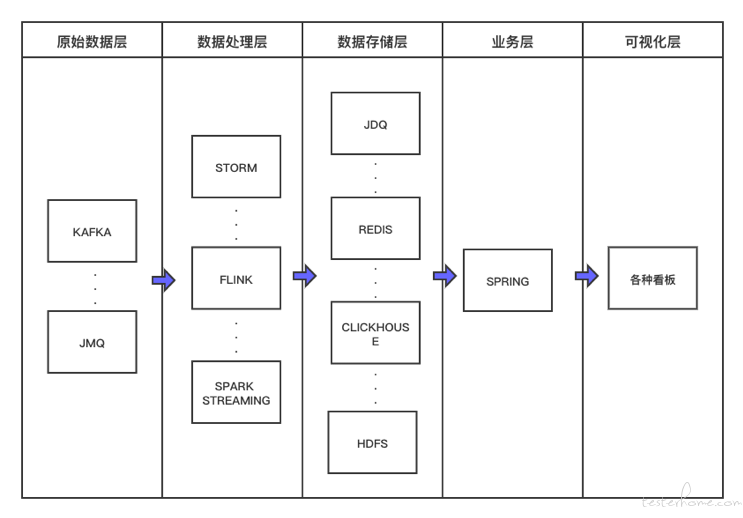

网易云音乐基于flink Kafka 的实时数仓建设实践 Aiq

Storm 消费kafka

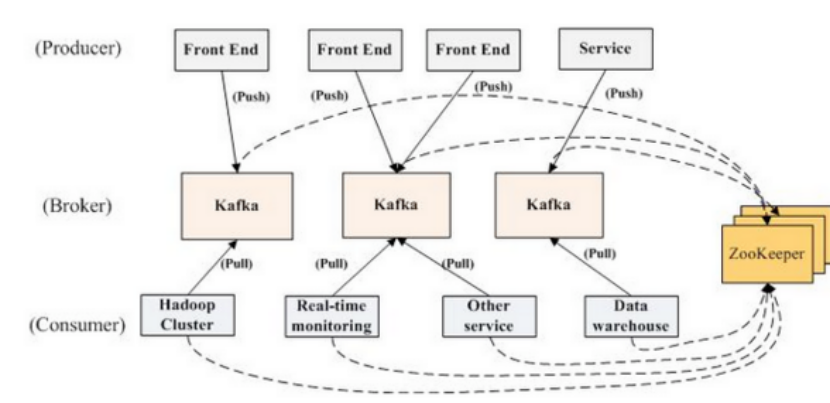

Storm 消费kafka-Kafka一代 消息队列 从上面的描述,我们可以看出,消息中间件之所以可以解耦消息的生产和消费,主要是它提供了一个存放消息的地方——生产者把消息放进来,消费者在从中取出消息进行处理。 那么这个存放消息的地方,应该采用什么 数据结构 呢? 在绝Dec 22, 19 · Kafka是最初由Linkedin公司开发,是一个分布式、支持分区的(partition)、多副本的(replica),基于zookeeper协调的分布式消息系统,它的最大的特性就是可以实时的处理大量数据以满足各种需求场景:比如基于hadoop的批处理系统、低延迟的实时系统、storm/Spark流式处理引擎,web/nginx日志、访问日志,消息服务等等,用scala语言编写,Linkedin于10年贡献给

Flume Kafka Storm Redis 大数据在线实时分析

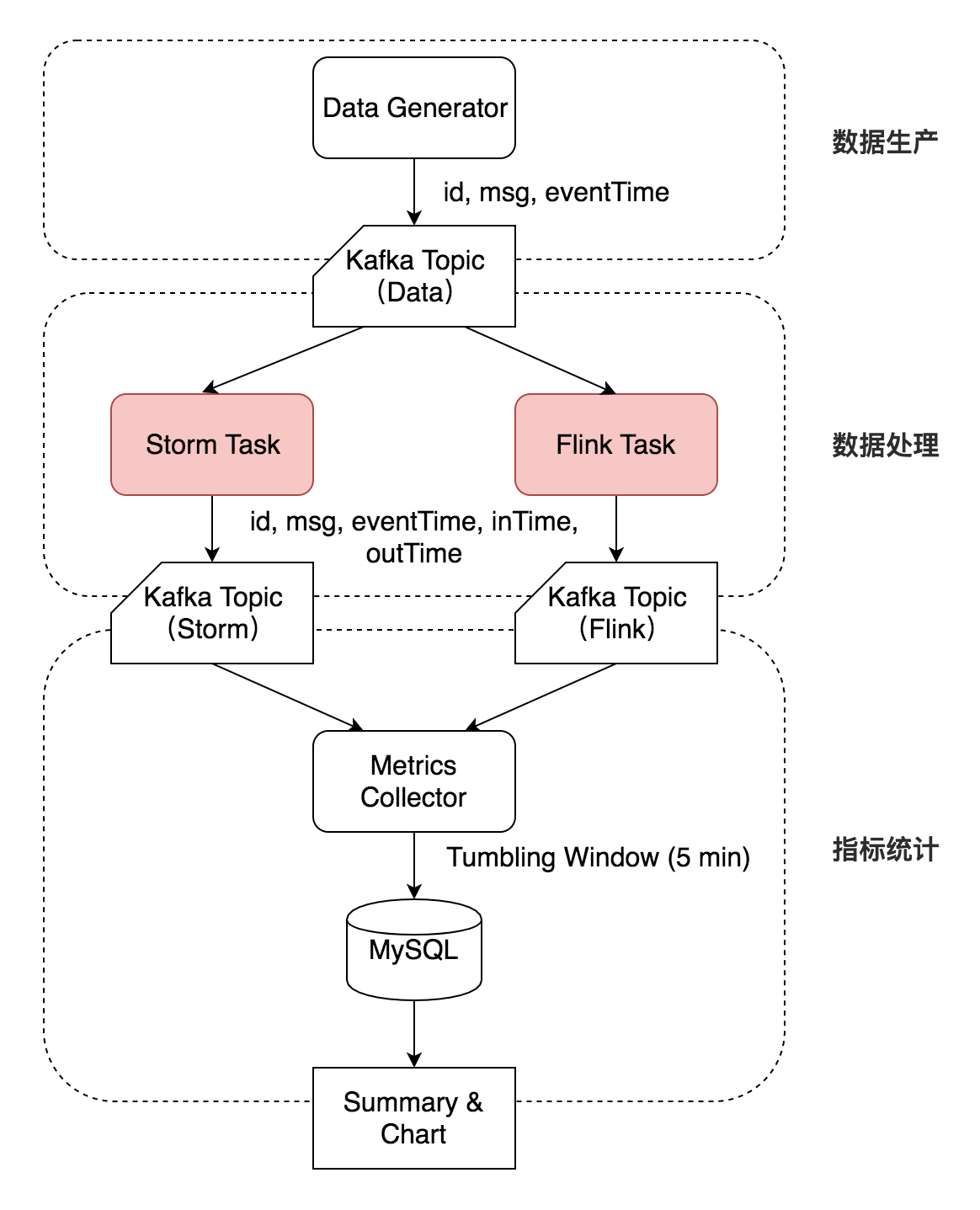

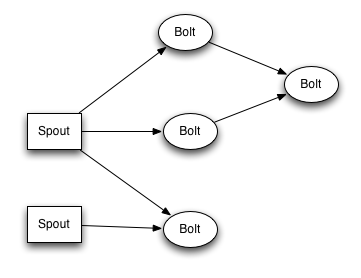

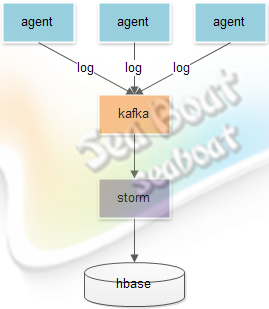

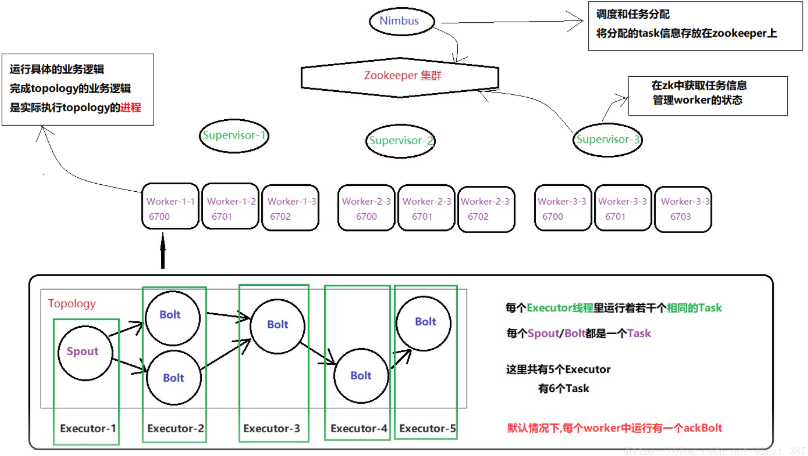

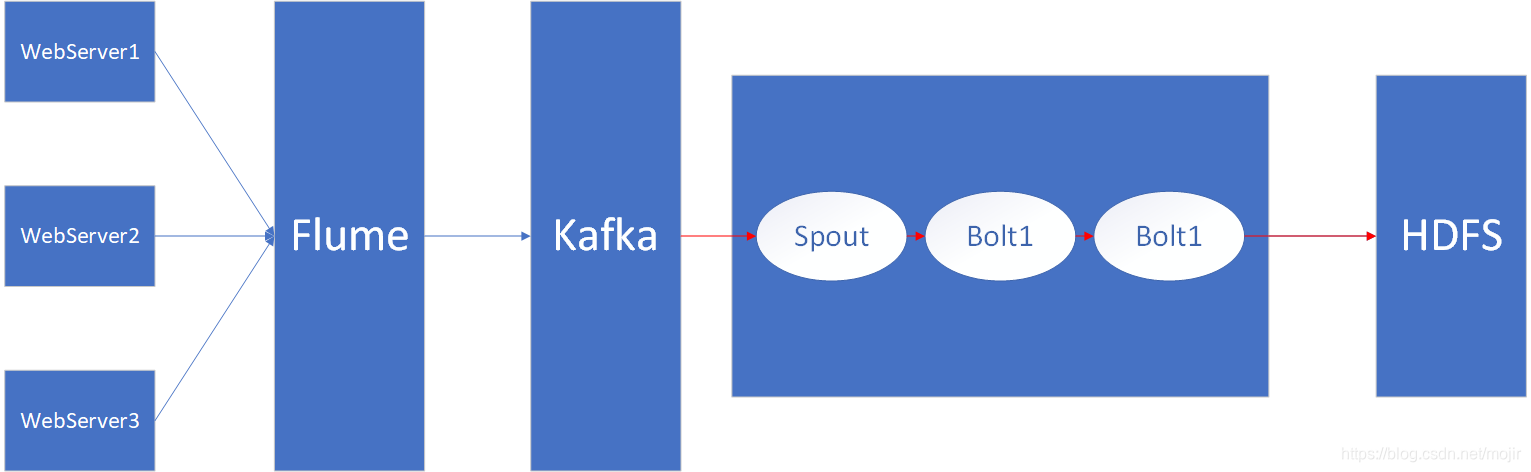

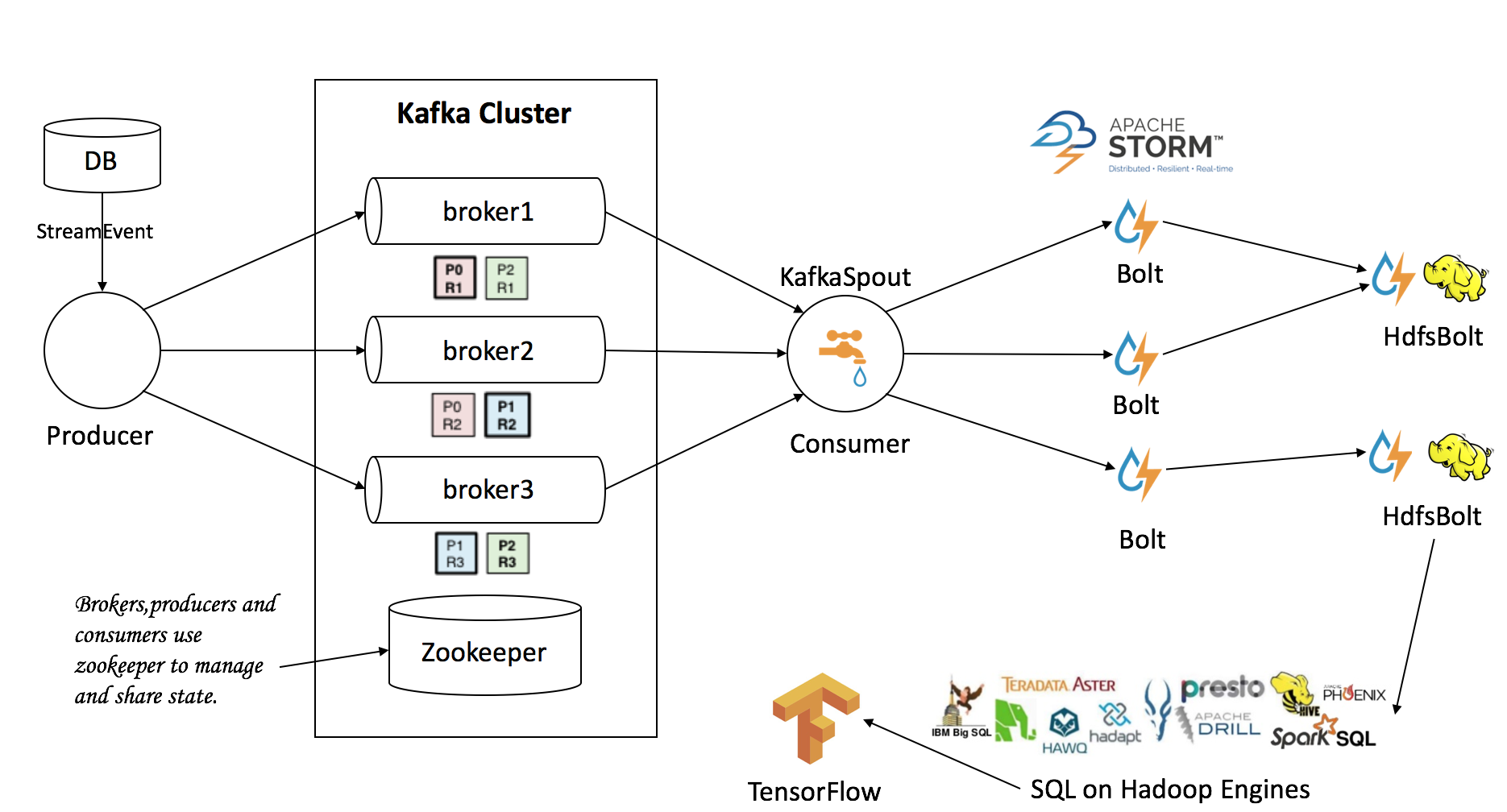

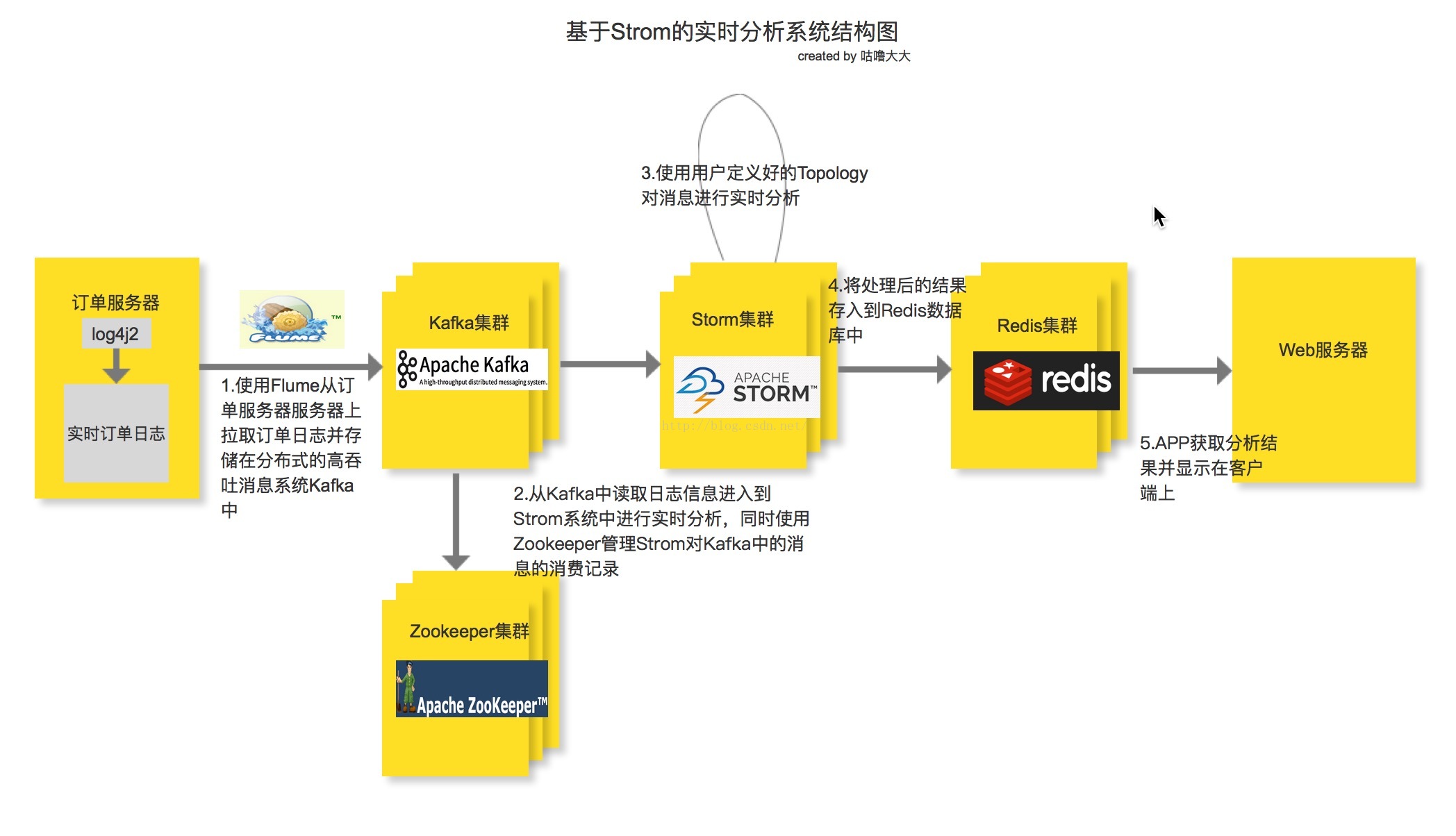

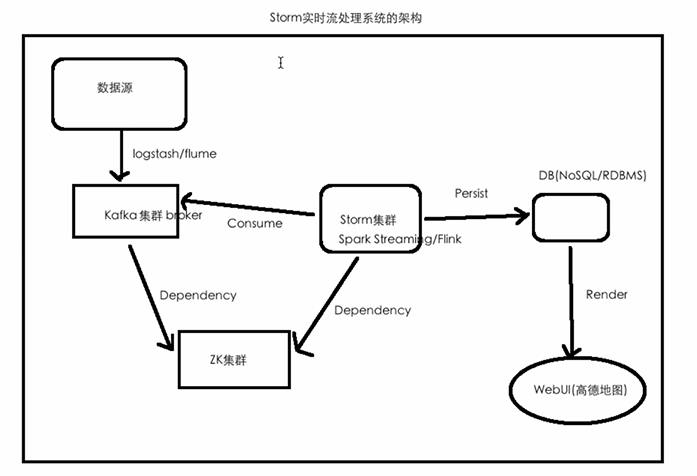

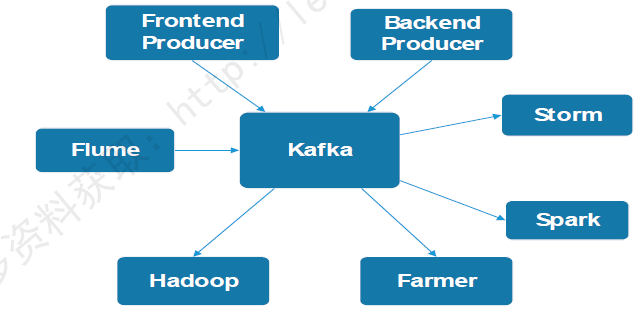

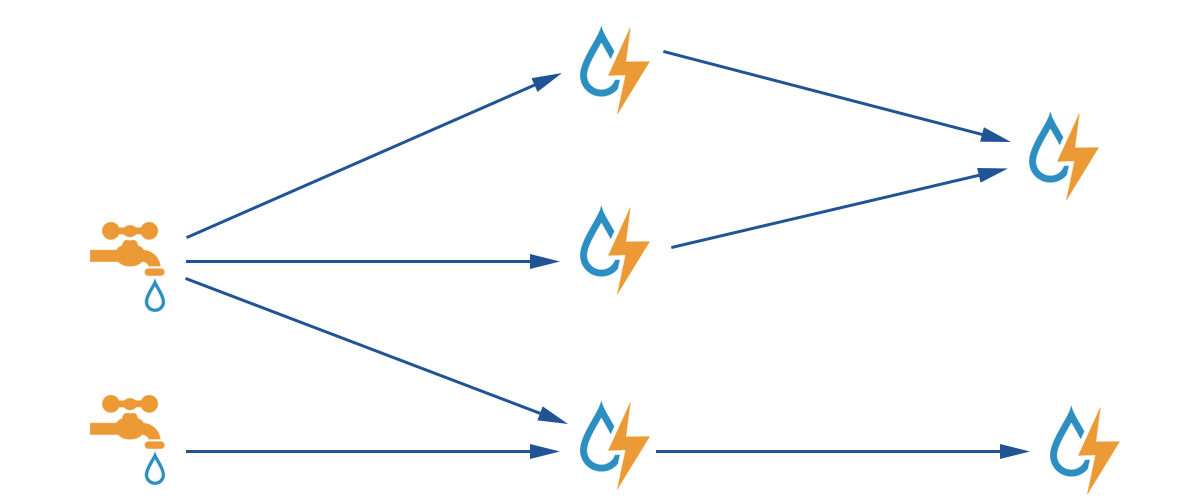

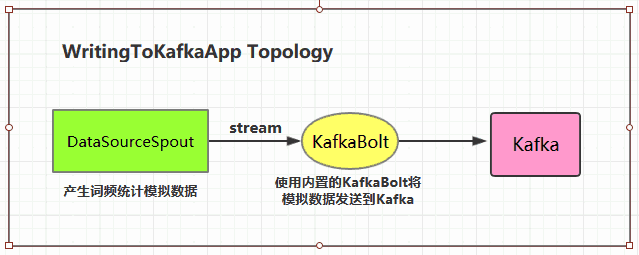

Apr 16, 18 · ### 41 整合思路 在这次的大数据实时处理系统的构建中,Kafka相当于是作为消息队列(或者说是消息中间件)的角色,其产生的消息需要有消费者去消费,所以Kafka与Storm的整合,关键在于我们的Storm如何去消费Kafka消息topic中的消息(kafka消息topic中的消息正是由Flume采集而来,现在我们需要在Storm中对其进行消费)。Mar 18, 16 · storm和kafka结合,实质上无非是之前我们说过的计算模式结合起来,就是数据先进入kafka生产者,然后storm作为消费者进行消费,最后将消费后的数据输出或者保存到文件、数据库、分布式存储等等,具体框图如下:在storm中连接kafka使用的是域名映射到虚拟机上的kafka 2解决办法 有两种解决办法: 21 在windows的hosts文件中配置 IP和域名的映射 22 在kafka的配置文件serverproperties中添加参数advertisedhostname该参数用来配置返回的hostname值,把这个参数配置为外网IP地址即可

如果我配置错误的zkroot路径的情况下报如下异常: boot 2642 WARN Thread3 DCMZkUtils read children of /storm_kafkaApr 03, 18 · 使用storm trident消费kafka消息 阅读 451 0 storm通过保证数据至少被处理一次来保证数据的完整性,由于元祖可以重发,对于一些需要数据精确的场景,可以考虑用storm trident实现。Storm实时消费kafka数据 Posted on 19年10月26日 19年10月26日 by 逍遥子 首先给大家推荐一下我老师大神的人工智能教学网站。

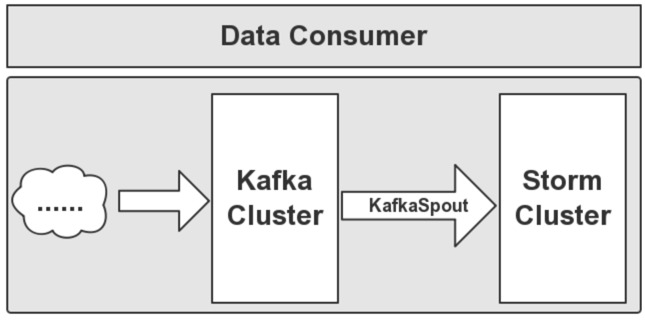

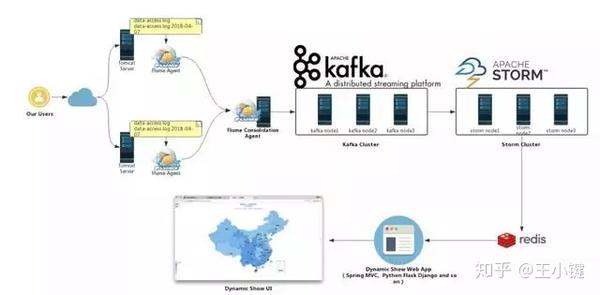

Apache Storm集成。 在本章中,我们将学习如何将Kafka与Apache Storm集成。 关于Storm Storm最初是由内森·马兹(Nathan Marz)和BackType团队创建的。在短时间内,Apache Storm成为分布式实时处理系统的标准,该系统使您可以处理大量数Feb 11, 18 · FlumeKafkaStormRedis实时分析系统基本架构 1) 整个实时分析系统的架构是 2) 先由电商系统的订单服务器产生订单日志, 3) 然后使用Flume去监听订单日志, 4) 并实时把每一条日志信息抓取下来并存进Kafka消息系统中, 5) 接着由Storm系统消费Kafka中的消息,Jan 12, 15 · 大数据架构:flumengKafkaStormHDFS 实时系统组合 1)数据采集 负责从各节点上实时采集数据,选用cloudera的flume来实现 2)数据接入 由于采集数据的速度和数据处理的速度不一定同步,因此添加一个消息中间件来作为缓冲,选用apache的kafka 3)流式计算 对采集到

流计算框架flink 与storm 的性能对比 美团技术团队

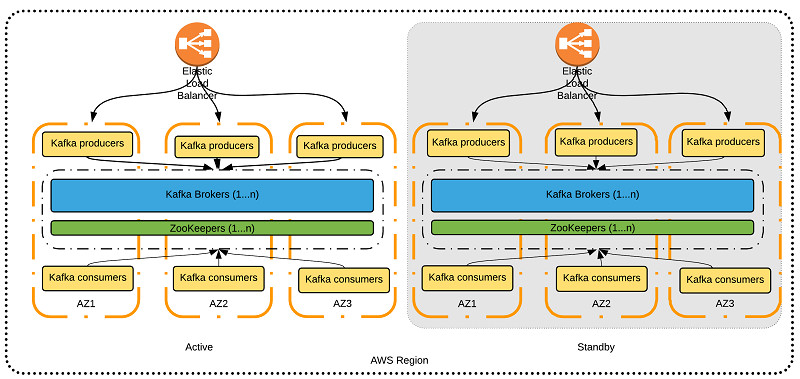

关于在aws 上运行apache Kafka 的最佳实践 亚马逊aws官方博客

Dec 28, 18 · Kafka适合离线和在线消息消费。 Kafka消息保留在磁盘上,并在群集内复制以防止数据丢失。 Kafka构建在ZooKeeper同步服务之上。 它与Apache Storm和Spark非常好地集成,用于实时流式数据分析。 好处 以下是Kafka的几个好处 可靠性 Kafka是分布式,分区,复制和容错的。随着Kafka版本的升级,Storm作为消费者对接Kafka 010x版本的方式上,与之前存在差异,现将新的方式记录下来,为以后遇到使用Storm实时处理新版Kafka数据的场景时提供参考。 01 架构简介Jan 13, · pip install kafka pip install kafka python 如果想要完成 负载均衡 ,就需要知道kafka的分区机制,同一个主题,可以为其分区,在生产者不指定分区的情况,kafka会将多个消息分发到不同的分区,消费者订阅时候如果不指定服务组,会收到所有分区的消息,如果指定了

One Rain S Blog

Kafka 牛客博客

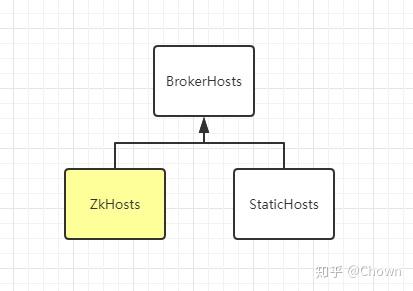

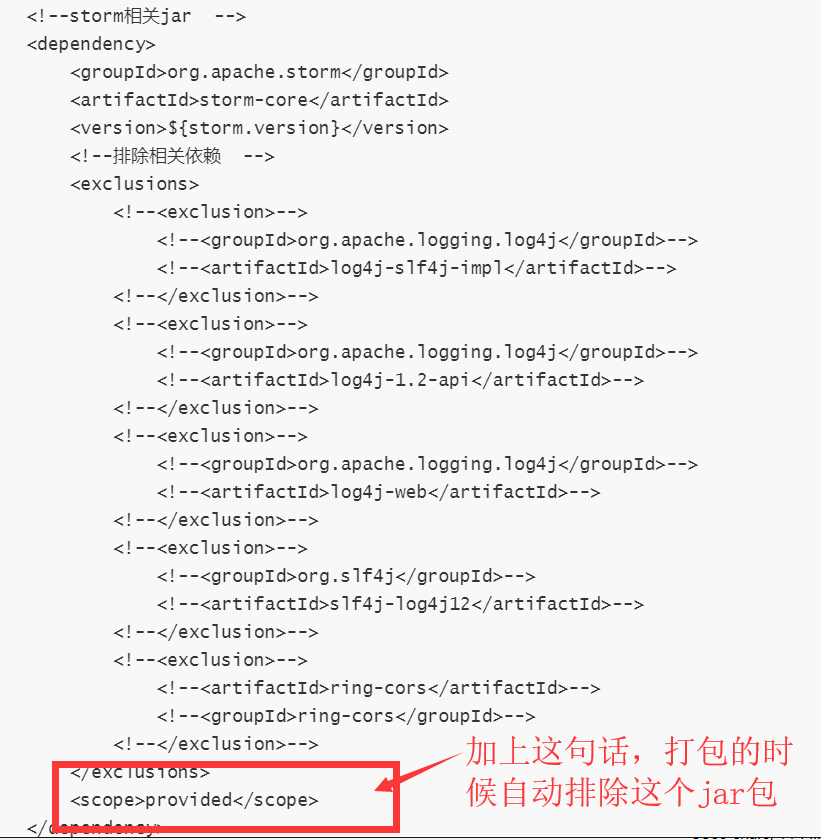

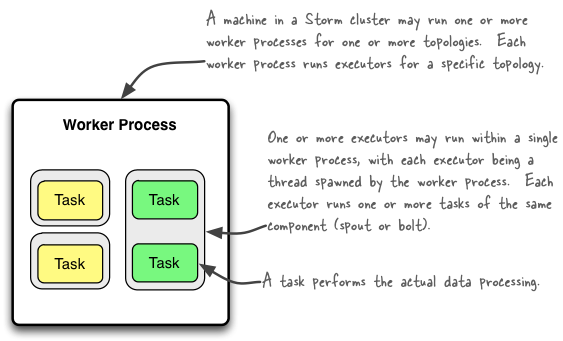

Storm 消费kafka原 送 Doris 限量T恤,快来围观! >>> 一个拓扑( Topology包括Spout、Bolt)提交会被分发到storm集群中的某个supervsion中,supervsion包含多个worker, 一个worker下包括多个线程池,Spout、Bolt会被分配到这些线程池里并行进行计算。 // storm中任务提交有两种方式,一种方式是本地模式,另一种是集群模式。 //在storm集群中,worker是用来分配的资源。 如果一个程序没Jul 15, 19 · Kafka强依赖ZK,如果想要使用Kafka,就必须安装ZK,Kafka中的消费偏置信息、kafka集群、topic信息会被存储在ZK中 一、Kafka 单节点部署 Kafka中单节点部署又分为两种,一种为单节点单Broker部署,一种为单节点多Broker部署。Sep 28, 18 · 版本: kafaka(100) storm(113) stormkafkaclient(113)ITPUB博客每天千篇余篇博文新资讯,40多万活跃博主,为IT技术人提供全面的IT资讯和交流互动的IT博客平台中国专业的IT技

Storm与kafka结合 王帆的专栏 Csdn博客 Storm与kafka

Storm学习记录 七 Flume Storm Kafka整合 在知识的海洋中遨游 程序员宅基地 程序员宅基地

Sep 05, 16 · 创建消费kafka的spout,直接用storm提供的KafkaSpout即可。 创建处理从kafka读取数据的Bolt,JsonBolt负责解析kafka读取到的json并发送到下个Bolt进一步处理(下一步处理的Bolt不再写,只要继承BaseRichBolt就可以对tuple处理)。Apache Kafka起源于LinkedIn,后来于11年成为开源Apache项目,然后于12年成为Firstclass Apache项目。Kafka是用Scala和Java编写的。 Apache Kafka是基于发布订阅的容错消息系统。 它是快速,可扩展和设计分布。_来自Apache Kafka 教程,w3cschool编程狮。Jul 02, 15 · 这里,我们使用Flume作为日志收集系统,将收集到的数据输送到Kafka中间件,以供Storm去实时消费计算,整个流程从各个Web节点上,通过Flume的Agent代理收集日志,然后汇总到Flume集群,在由Flume的Sink将日志输送到Kafka集群,完成数据的生产流程。

Kafka 维基百科 自由的百科全书

一文搞懂kafka核心基础知识

Aug 29, 16 · customer负责消费消息日志,如果需要时时消费,则可以使用storm或者spark streaming,如果离线消费,可以使用mapreduce。 kafka总结 kafka可以完全应用到不同的业务场景中,配合zookeeper,保证系统的高可用性。监控storm消费kafka报如下异常 Oct , 15 PM orgapachecatalinacoreStandardWrapperValve invoke SEVERE Servletservice() for servlet3kafkapython的基本使用 最简单使用实例 1消费端 from kafka import KafkaConsumer consumer = KafkaConsumer('my_topic', group_id= 'group2', bootstrap_servers= 'localhost9092') for msg in consumer print(msg) 第1个参数为 topic的名称 group_id 指定此消费者实例属于的组名,可以不指定

06 Storm 新华三集团 H3c

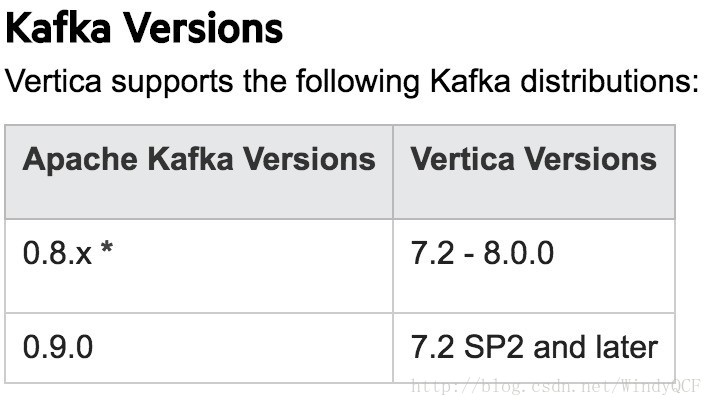

Vertica实时消费kafka实现 极客分享

Sep 05, 16 · 在流式计算中,Kafka一般用来缓存数据,Storm通过消费Kafka的数据进行计算。Aug 07, 19 · 原理 如何仔细阅读过关于Flume、Kafka、Storm的介绍,就会知道,在他们各自之间对外交互发送消息的原理。 在后面的例子中,主要对Flume的sink进行重构,调用kafka的消费生产者(producer)发送消息;在Storm的spout中继承IRichSpout接口,调用kafka的消息消费者(Consumer)来接收消息,然后经过几个自定义的Bolt,将Apr 19, 21 · Last Release on Apr 19, 21 2 Apache Kafka 1,162 usages orgapachekafka » kafka Apache Apache Kafka

Storm Hbase 事件中心 流处理场景分析上 微信公众平台精彩内容 微信邦

基于kafka和storm的车辆套牌实时分析存储系统

Oct 09, 15 · stormkafka(storm spout作为kafka的消费端),storm是grovvy写的kafka是scala写的stormkafka storm连接kafkaconsumer的插件下载地址:https//githubcom/wurstmeister/stormkafka08plus除了需要storm和kafka相关jar包还需要googlecollections10jar以及zookeeper相关包curatorfNov 14, 19 · flink整合kafka实现消费和生产 1 flink通常整合kafka实现消费和生产。在很大原因上是由于kafka很适合流处理 在我们平常的业务场景中,仅读取,写入和存储数据流是不够的,更多目的是启用流的实时处理。Oct 21, 18 · Storm 集成 Kafka 简单实现 kafka 有比较大的吞吐量,不仅在实时流数据处理上有很大的优势,更大的优势还在于它的缓存机制, storm 做实时流数据的处理也是很不错的框架,比较合适的使用场景在于 kafka 对流数据的缓存,然后 storm作为kafka 的 消费者 , kafka作为storm 的spout实现对实时数据的处理 以下为 storm 集成 kafka 简单实现的demo 由于 kafka 和 storm Storm Kafka

网易云音乐基于flink Kafka 的实时数仓建设实践 Aiq

Storm Kafka 入门 知乎

使用kafka作为数据源,给storm的后续bolt提供数据的例子,还有 为啥要inputgetString(4),这个4怎么来的。 先看main方法,步骤很清新的。 package comlxkstorm;Apr 19, 21 · Binary downloads Scala 212 kafka_tgz ( asc, sha512) Scala 213 kafka_tgz ( asc, sha512) We build for multiple versions of Scala This only matters if you are using Scala and you want a version built for the same Scala version you use Otherwise any version should work (213 is recommended)Oct , 15 · Flume和Kafka本身是很相似的系统,都能无压力传输很大的数据量。 细节上他们当然有很多不同,但是总结下来,如果你纠结到底是用Kafka还是Flume: 1 Kafka是pull based, 如果你有很多下游的Data Consumer,用Kafka; 2 Kafka有Replication,Flume没有,如果要求很高的容错性(Data High Availability),选kafka; 2

Storm 消费kafka 伯纳乌看台的个人空间 Oschina 中文开源技术交流社区

Flink 靠什么征服饿了么工程师

Dec 04, 17 · 你和老憨都订阅了topicA,每个人都要消费一份 完整的 不重复的 消息,怎么办? 今天又来了八条消息,要给你送的三个实例送八条消息,给老憨的五个实例送八条消息。 kafka懵逼了啊,我特么知道哪三个实例是你的,哪五个实例是老憨的!老子不干了! 足!Dec 01, · weixin_ 12 0350 首页 开源项目 监控storm消费kafka报异常Storm消费Kafka提交集群运行 1创建拓扑,配置KafkaSpout、Bolt KafkaTopologyBasicjava: package orgmortstormkafka;

大数据处理框架之strom Flume Kafka Storm整合 Cac 博客园

Bigdata Notes Storm集成kakfa Md At Master Heibaiying Bigdata Notes Github

Sep 03, 18 · Kafka 和传统的消息系统不同在于: • Kafka是一个分布式系统,易于向外扩展。 • 它同时为发布和订阅提供高吞吐量。 • 它支持多订阅者,当失败时能自动平衡消费者。 • 消息的持久化。 Kafka 和其他消息队列的对比:本文主要讲解 Kafka 是什么、Kafka 的架构包括工作流程和存储机制,以及生产者和消费者,最终大家还会掌握 Kafka 中几个最重要的概念,分别是 broker、producer、consumer、consumer group、topic、partition、replica、leader、follower,这是学会和理解 Kafka 的基础和必备内容,建议收藏。 1 定义 Kafka 是一个 分布式 的基于 发布/订阅模式 的消息队列(Message Queue),主要应用与大

Spark Storm消费kafka为啥不阻塞 消费kafka 运行在每个excutor 还是运行在driver Xuehuagongzi000的博客 Csdn博客 Storm消费kafka卡住

Storm 性能优化 Yellow S Blog

大型互联网平台日志系统 Filebeat Kafka Logstash Elastic Storm Mysql 小白的入门实战篇 技术岛 技术改变生活

Kafka Cokid

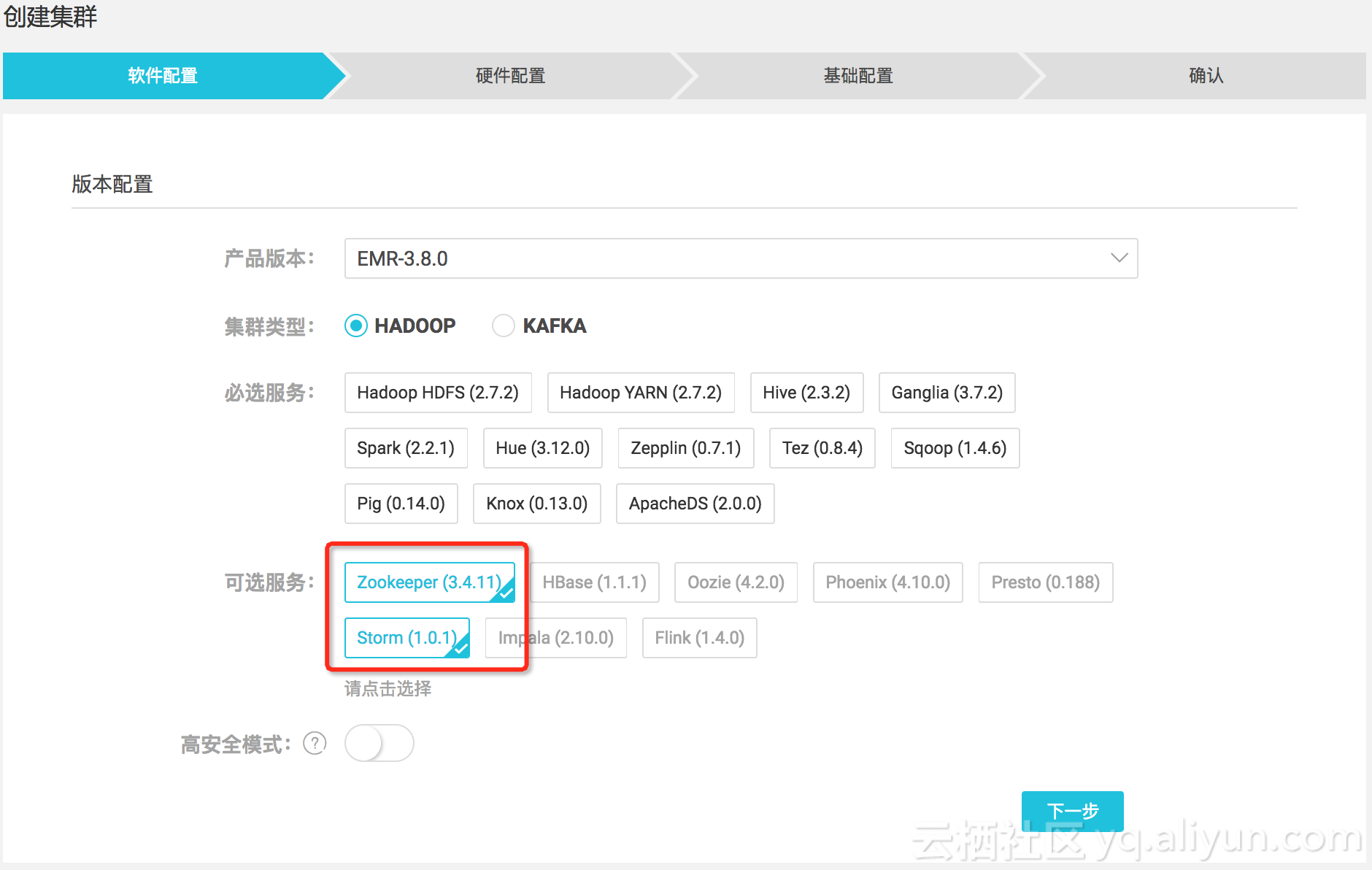

如何在e Mapreduce上提交storm作业处理kafka数据 阿里云开发者社区

Apache Kafka 基础 W3cschool

Flume Kafka Storm Redis 大数据在线实时分析

Apache Kafka和apache Storm的区别 Apache Kafka教程 Srcmini

Storm作为新消费者对接kafka 0 10 X 版本 Cigg153的博客 Csdn博客

Kafka优先级支持 Menina

基于flume Kafka和storm实现企业大数据平台的实时数据采集 简书

Storm Kafka 入门 知乎

如何基于kafka打造高可靠 高可用消息平台 京东云开发者社区

Kafka Storm Redis简单demo 简书

Storm消费kafka实现实时计算 Seaboat A Free Boat On The Sea 公众号 远洋号 Csdn博客

Storm 消费kafka 伯纳乌看台的个人空间 Oschina 中文开源技术交流社区

360深度实践 Flink 与storm 协议级对比 Segmentfault 思否

Storm Kafka 入门 知乎

Hdp Storm的kafka Kerberos认证 如风达的个人空间 Oschina 中文开源技术交流社区

Storm与kafka进行集成 Chain的博客 程序员宅基地 Kafka和storm集成 程序员宅基地

Flume Kafka Storm Redis构建大数据实时处理系统 实时统计网站pv Uv 展示 香飘叶子 51cto博客

Springboot整合storm和kafka Zyr S Blog

Flume Kafka Storm整合 Hongten 博客园

Storm Kafka与配置和代码集成 Daisylinux 博客园

Apache Kafka架构原理 Apache Kafka教程 Srcmini

解决java Lang Classnotfoundexception Storm Kafka Brokerhosts问题 华为云

Storm Kafka Kafkaspout原理分析 我爱我家

4 网上收集storm 讲解图 Xidianzxm 博客园

架构师详解 从0 1构建大数据平台 Null

Storm消费kafka监控 One Rain S Blog

18尚硅谷大数据技术之kafka

Kafka中topic的partition数量和customergroup的customer数量关系以及storm消费kafka时并行度设置问题总结 尚码园

Apache Storm项目 H5 Processon免费在线作图 在线流程图 在线思维导图

Storm 消费kafka 伯纳乌看台的个人空间 Oschina 中文开源技术交流社区

Kafka 命令 Api 有组织在

Kafka 6 Kafka Streams Changfei S Tech Blog

最简单流处理引擎 Kafka Streams简介 极术社区 连接aiot 开发者与生态服务

Kafka集群安裝部署 自带zookeeper

Github Xuminwlt J360 Kafka Storm Storm使用案例 Simple Storm Storm Kafka Trident Stream And Example

Kafka Storm Hdfs Architecture Design Whoami

Storm消费 日志服务 阿里云

Flume Kafka Storm Mysql Ssm 高德地图热力图项目需求 简书

核心业务 瘦身 进行时 手把手带你搭建海量数据实时处理架构 Sequoiadb技术博客 Sequoiadb巨杉数据库

Kafka 使用java实现数据的生产和消费demo 虚无境的博客

尚硅谷大数据技术之kafka第1章kafka概述 技术分享 尚硅谷

Log4j Kafka Storm Mongodb Mysql 日志处理

Apache Kafka 消费端 顺序消费的实现 小小工匠 51cto博客

教程 运输iot中的kafka 腾讯新闻

Flume Kafka Storm Redis实时分析系统基本架构 行人事 知天命 Csdn博客

Storm综合项目实战 Thpffcj的树洞

Kafka 牛客博客

带你涨姿势的认识一下kafka Consumer Segmentfault 思否

如何基于kafka 打造高可靠 高可用消息平台

Kafka深度剖析 技术圈

Kafka中topic和副本的关系图简介 程序员大本营

Kafka 维基百科 自由的百科全书

消息队列ckafka Storm 接入ckafka 最佳实践 文档中心 腾讯云

Storm Kafka与配置和代码集成 Daisylinux 博客园

Storm学习 六 Kafka原理及安装 Livan1234的博客 Csdn博客

Kafka Storm Elasticsearch整合实时数据分析实践 航行学园

Flume Kafka Storm Redis 大数据在线实时分析

Storm Kafka与配置和代码集成 Daisylinux 博客园

Storm 读取不到对应的kafka数据 Bymain的博客 程序员宅基地 程序员宅基地

Flume Kafka Storm Redis构建大数据实时处理系统 实时统计网站pv Uv 展示 香飘叶子 51cto博客

基于storm处理kafka数据 Weijunzhe S Blog

Kafka 入门 学习大数据网

关于在aws 上运行apache Kafka 的最佳实践 亚马逊aws官方博客

Kafka中topic的partition数量和customergroup的customer数量关系以及storm消费kafka时并行度设置问题总结 尚码园

Storm作为新消费者对接kafka 0 10 X 版本 Cigg153的博客 Csdn博客

Apache Kafka 基础 W3cschool

Storm 性能优化 Yellow S Blog

18 5 12 Storm数据源kafka堆积

基于flink 的实时数据消费应用 功能质量保障方法 贝克街的捉虫师

Kafka实战 Kafka到storm 哥不是小萝莉 博客园

06 Storm 新华三集团 H3c

Storm消费kafka异常 Topic其中两个分区达到某个值不进行消费 持续阻塞 Jast Csdn博客

Kafka Spark Streaming如何保证exactly Once语义 大数据技术与架构 商业新知

Storm消费kafka监控 One Rain S Blog

Storm集成kafka 来唧唧歪歪 Ljjyy Com 多读书多实践 勤思考善领悟

基于storm的大数据指标实时计算方法

Flume Kafka Storm Redis构建大数据实时处理系统 知乎

构建流式计算卖家日志系统应用实践

0 件のコメント:

コメントを投稿